技术改变生活,也改变了诈骗,AI新骗局来袭,诈骗成功率接近100%。5月22日,话题#AI诈骗正在全国爆发#冲上微博热搜,只需要提供一张带脸的照片,就可以把自己置换成视频、电视剧中的男(女)主角,而且拟真度非常高,毫无违和感。AI换脸、合成人声等新型诈骗频发,和你视频对话的可能不是亲友本人!

AI换脸

通过视频确认过长相仍被骗

据“平安包头”介绍,4月20日11时40分左右,福州市某科技公司法定代表人郭先生的好友突然通过微信视频联系到他,两人经过短暂聊天后,好友告诉郭先生,自己的朋友在外地投标,需要430万元保证金,且需要公对公账户过账,所以想要借用郭先生公司的账户走一下账。好友向郭先生要了银行卡号,声称已经把钱打到郭先生的账户上,还把银行转账底单的截图通过微信发给了郭先生。基于视频聊天信任的前提下,郭先生没有核实钱是否到账,于11时49分先后分两笔把430万元给对方打了过去。钱款转账后,郭先生给好友微信发了一条消息,称事情已经办妥。但让他没想到的是,好友回过来的消息竟然是一个问号。

郭先生拨打好友电话,对方说没有这回事,他这才意识到遇上了“高端”骗局,对方通过智能AI换脸技术,佯装成好友对他实施了诈骗。

“从头到尾都没有和我提借钱的事情,就说会先把钱给我打过来,再让我给他朋友账户转过去,而且当时是给我打了视频的,我在视频中也确认了面孔和声音,所以才放松了戒备。”郭先生说。

4月20日12时21分,包头市电信网络犯罪侦查局接到福建省福州市公安局刑侦支队的外协请求,称福建省一知名民营企业负责人被骗走430万元,而涉案的银行卡为包头市蒙商银行对公账户,希望包头警方能够帮忙进行紧急止付。

包头市公安局电信网络犯罪侦查局立即启动“包头市警银联动绿色查询机制”,当班民警以最快速度完成核查、报审程序,第一时间将涉案卡的信息通报至蒙商银行相关部门。在银行的全力协助下,仅用时10分钟,就将该诈骗账户内的336.84万元被骗资金成功拦截。同时,向福州市公安局警方提供了剩余款项93.16万元资金流出信息,为深入突破该案剩余资金查找提供了突破方向。目前,福建警方与包头警方对此资金正在全力追缴当中。

在这起骗局中,骗子防不胜防的程度,超出正常认知的仿真度,令人不寒而栗。据警方介绍,AI诈骗还有不少花样,通过声音合成、AI换脸、转发语音等手段,成功率竟接近100%。

合成人声

AI“老板”“好友”口音逼真

在最新技术的加持下,AI合成语音正越来越逼真,对话效果越来越好。不过新技术也被一些犯罪分子利用。McAfee今年4月面向美国、英国、法国、德国、澳大利亚、印度和日本7个国家的7054名成年受访者开展调查。结果显示10%的成年受访者曾遭遇AI语音诈骗。

记者留意到,利用AI技术进行语音诈骗的案例并非近期新发。早在2019年,《华尔街日报》就曾报道,有诈骗分子利用AI模仿了英国某能源公司的母公司CEO声音,成功让该能源公司高管相信自己正在与母公司的老板通电话,并诱骗其通过匈牙利供应商向诈骗分子转账22万欧元。被骗高管表示,在整个通话过程中,老板的德国口音非常逼真,使其对声音的真实性没有任何怀疑,直到被要求再次转账时才发觉了异常。在立案调查后,警方发现资金被转到匈牙利供应商的银行账户,随后又转往墨西哥和其他地方,但嫌疑人的具体身份无法确定。

在国内,也有媒体曾于2019年报道不法分子利用AI技术制作真人语音,然后通过社交平台冒充受害者好友骗取钱财。据新华社报道,2019年9月,市民陈先生收到朋友的一条微信语音,提出借款5000元。因为收到“货真价实”的语音,陈先生并未怀疑,马上通过微信向其转账。“好友”见状又问陈先生可否再转9000元。陈先生才警觉起来,通过电话联系该名好友,发现自己上当受骗。经警方初步了解,诈骗分子通过获取陈先生好友微信账号、密码及语音等信息,博取陈先生信任后,以“朋友”微信及语音对其进行诱骗。

2021年初,公安部网安局曾发文提醒公众,注意防范合成声音和AI换脸等人工智能新型诈骗手段。

焦点

AI换脸低门槛低成本

瑞莱智慧副总裁唐家渝告诉记者,早期的换脸视频,由于技术不成熟、不完善,存在“微表情不自然”、“面部边缘有锯齿”等明显换脸痕迹。但随着技术的不断成熟,近年来制作传播的换脸视频,足以达到以假乱真的水平。

犯罪分子是如何生成大批量以假乱真的AI人脸合成视频的呢?

中国信通信院云大所人工智能部副主任石霖向记者分析,从过往新闻的描述来看,犯罪嫌疑人应该是使用的类似CrazyTalk等软件,利用“重现”的方式将被害人的照片伪造成眨眼、点头、张嘴等动态视频。由于这类软件对技术算法进行了封装,所以使用成本和难度大大降低。

唐家渝告诉记者,目前业内已经有很多成熟的生成类软件工具。并且现在很多代表性的生成方法已经被开源,技术走向公开和轻量化,也有黑产分子售卖AI换脸软件及教程。普通人很快就能上手,通常生成一段用于身份核验的动态换脸视频,十几分钟就可以实现。

记者梳理发现,“AI换脸”技术“走红”以来,曾出现过不少售卖“AI换脸”服务的团伙。据新华视点报道,记者早前在淘宝网搜索“AI换脸”、“deepfake”等,出现了不少提供换脸软件及换脸视频制作的售卖信息。

事实上,此前记者也曾在QQ群搜索到了“AI换脸高级群”、“变换脸-AI换脸”等提供“AI换脸”服务的群组,卖家声称“五分钟视频换脸100元”“学教程2000元包教包会”“不限视频内容”“所有明星都能换”。其中一名工作人员透露,其制作的“AI换脸视频”甚至可以通过人脸识别。

法规政策陆续出台遏制黑灰产

记者观察到,自“AI换脸”乱象出现以来,国家网信办、各地网警加紧对涉及“AI换脸”违规违法现象进行整治,相关的法规政策也在逐渐出台。

目前《中华人民共和国民法典》《网络音视频信息服务管理规定》《网络信息内容生态治理规定》等我国多部法规均涉及深度合成应用的规范。去年1月,国家网信办最新公布的《互联网信息服务深度合成管理规定(征求意见稿)》(下称《规定》)对深度合成内容的用途、标记、使用范围以及滥用处罚作出具体规定,尤其对作为深度合成服务提供者的平台方进行了审核、评估、监管等提出要求。

不过,仍有多名专家指出,目前对于深度合成服务与应用方面还需要进一步细化和明确。

浙江垦丁律师事务所元宇宙法律研究部成员程念表示,深度合成技术相关的一些概念界定、平台责任边界等问题的确定在法律上面临挑战。

对于利用AI技术进行的犯罪行为,北京京师律师事务所律师王琮玮表示,《规定》拟规范的是提供符合市场需求的应用技术,对于这一技术被滥用,甚至从事违法犯罪行为并不能起到限制或禁止的作用。“当AI技术的使用上升到刑事法律层面,需要用《刑法》来调整。”

唐家渝则进一步指出,在AI技术合规性方面,目前还缺乏一套科学严谨的标准机制。未来应引导学术界、产业界不断加强技术研究,利用技术创新、技术对抗等方式,持续提升和迭代深度合成检测能力,并扩展深度合成溯源、深度合成鉴定等方面的研究。

揭秘

提供3秒音频即可克隆特定人物声音

有业内人士指出,其实AI语音合成技术应用已久,例如地图导航的明星语音包便利用了类似技术。但以往制作这类语音包时,通常要求说话者在安静环境下念出一定量的录制文本,例如一篇5-10分钟的文章,供AI获取足够多的发音特征,再进行合成;如果遇到说话者没读过的生僻字,AI就可能出现发音失真等问题。不过随着技术不断发展,如今AI已可对发音进行一定的推理模仿,即使是说话者从未读过的字眼,也能模仿出相似音色,因此对语音素材要求不断下降。越来越低的技术应用门槛确实给不法分子提供了可乘之机。

McAfee调查报告也指出,其安全研究人员在互联网上发现了十几种AI语音合成工具。研究人员使用其中一种工具进行测试,发现只要提供3-4秒的录音,这个免费AI工具就能创造出一个约有85%相似的克隆人声。

虽然风险显而易见,但AI语音合成技术的发展仍在不断提速。今年1月,微软团队发布一个AI语音合成模型VALL-E。据介绍,该模型只需要说话者读出3秒指定内容的音频作为训练素材,即可精确地模拟说话者的声音。从已公开的合成语音效果来看,VALL-E不仅能还原说话者的音色,还能模仿说话者的愤怒、困倦、愉悦等多种情绪,甚至连说话者的环境背景音也能准确还原。

微软也意识到该模型可能助长恶作剧和欺骗的可能性。在相关论文中,微软表示“由于VALL-E可以合成符合说话人身份的语音,因此滥用模型可能会带来潜在风险,例如欺骗语音识别或冒充特定说话人。为了降低此类风险,可以构建一个检测模型来区分音频剪辑是否由VALL-E合成。在进一步开发模型时,我们还将把微软人工智能原则付诸实践。”

互联网平台已出现人声克隆音视频

随着AI技术应用门槛不断下降,近期国内部分互联网平台也有网民发布基于明星语音素材训练而成、几可乱真的AI音视频。

在哔哩哔哩等互联网平台上,记者发现不少网民已利用Sovits4.0、DiffSinger等开源AI项目制作以人声克隆为主题的音视频。这些音视频主要通过提取一个特定真人的声音作为训练数据,让AI模型习得其声线,实现歌曲翻唱等目标。从平台搜索结果可以看到,相关音视频涵盖已故艺人、当红歌手、游戏角色等多领域的人物声音。部分网民也在相关音视频的评论区表达对这类AI技术的担忧。

在防范被提取声音数据方面,McAfee建议网民在社交媒体分享内容时,考虑通过隐私设置将可见范围限制在朋友和家人身上:社交媒体内容的可见范围越广泛,信息泄露的风险就越大。

在防范AI语音诈骗方面,McAfee建议公众与家庭成员等亲密联系人约定一个“关键词”:一旦出现不同寻常的求助信息,可以用关键词来确认对方是真人还是AI语音。此外,公众对任何来电都应该保持理性,可通过询问具体信息、回拨号码等方式确认来电者身份,切忌因一时激动而盲目采取行动。

深读

监管AI换脸、虚拟人等技术

深度合成新规已于1月10日实施

深度合成技术被戴上紧箍。据了解,《互联网信息服务深度合成管理规定》(以下简称“《规定》”)于1月10日起施行,从技术提供者、服务使用者以及监管等各方面,对深度合成技术应用提出规范。

所谓“深度合成技术”,是指利用以深度学习、虚拟现实为代表的生成合成类算法制作文本、图像、音频、视频、虚拟场景等信息的技术,包括文本转语音、音乐生成、人脸生成、人脸替换、图像增强等技术。目前该技术已应用于传媒、影视制作、社交娱乐、教育以及电子商务等行业,如修复历史老照片、AI换脸、虚拟主播等。最近火热的聊天机器人ChatGPT,“科技与狠活”AIGC(AI-Generated content 即AI生产内容)、二级市场热炒的数字人等均属于深度合成技术领域。

记者注意到,《规定》对深度合成服务提供者、技术支持者等各方责任义务进行了系统性制度设计,包括算法机制机理审核、信息内容管理、安全评估等。比如,新规要求深度合成服务提供者主体不得利用深度合成服务从事违法活动,还要建立健全用户管理制度,制定和公开管理规则等,加强深度合成内容管理,建立健全辟谣机制和申诉、投诉、举报机制。

《规定》要求深度合成服务提供者落实信息安全主体责任,建立健全管理制度和技术保障措施,制定公开管理规则、平台公约,对使用者进行真实身份信息认证,明确应用程序分发平台应当落实安全管理责任,核验深度合成类应用程序相关情况。

此外,《规定》也提出了明确的数据和技术管理规范。其中包括,深度合成服务提供者和技术支持者提供人脸、人声等生物识别信息编辑功能的,应当提示深度合成服务使用者依法告知被编辑的个人,并取得其单独同意;

同时,《规定》指出,提供智能对话、合成人声、人脸生成、沉浸式拟真场景等生成或者显著改变信息内容功能的服务的,应当进行显著标识,避免公众混淆或者误认。要求任何组织和个人不得采用技术手段删除、篡改、隐匿相关标识。

AI诈骗常用手法

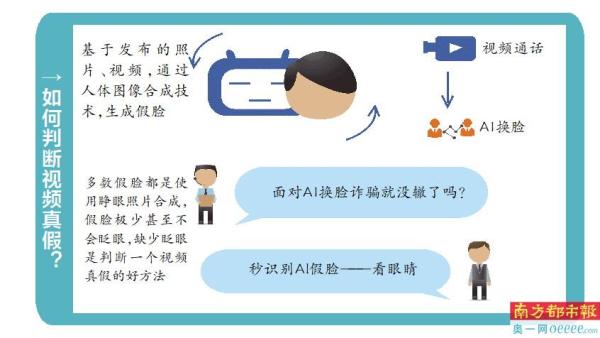

AI换脸:人脸效果更易取得对方信任,骗子用AI技术换脸,可以伪装成任何人,再通过视频方式进行信息确认。骗子首先分析公众发布在网上的各类信息,根据所要实施的骗术,通过AI技术筛选目标人群。在视频通话中利用AI换脸,骗取信任。

声音合成:骗子通过骚扰电话录音等来提取某人声音,获取素材后进行声音合成,从而可以用伪造的声音骗过对方。

转发微信语音:骗子在盗取微信号后,便向其好友“借钱”,为取得对方的信任,他们会转发之前的语音,进而骗取钱款。尽管微信没有语音转发功能,但他们通过提取语音文件或安装非官方版本(插件),实现语音转发。

AI程序筛选受害人:骗子利用AI来分析公众发布在网上的各类信息,根据所要实施的骗术对人群进行筛选,在短时间内便可生产出定制化的诈骗脚本,从而实施精准诈骗。

如何防范AI诈骗?

多重验证,确认身份

如果有人要求你分享个人身份信息,如你的地址、出生日期或名字,要小心;对突如其来的电话保持警惕,即使是来自你认识的人,因为来电显示的号码可能是伪造的;网络转账前要通过电话等多种沟通渠道核验对方身份,一旦发现风险,及时报警求助;如果有人自称“熟人”、“领导”通过社交软件、短信以各种理由诱导你汇款,务必通过电话、见面等途径核实确认,不要未经核实随意转账汇款,不要轻易透露自己的身份证、银行卡、验证码等信息。

保护信息,避免诱惑

不轻易提供人脸、指纹等个人生物信息给他人,不过度公开或分享动图、视频等;陌生链接不要点,陌生软件不要下载,陌生好友不要随便加,防止手机、电脑中病毒,微信、QQ等被盗号。

提高安全防范意识

公检法没有安全账户,警察不会网上办案,如果有网络警察说你犯事了,让他联系你当地的派出所,你也可以主动打110咨询;如不慎被骗或遇可疑情形,请注意保护证据立即拨打96110报警。

采写:南都记者 蒋琳 李伟锋 叶露

整合:朱林

来源:新华社 中国新闻社 北京日报 平安包头等